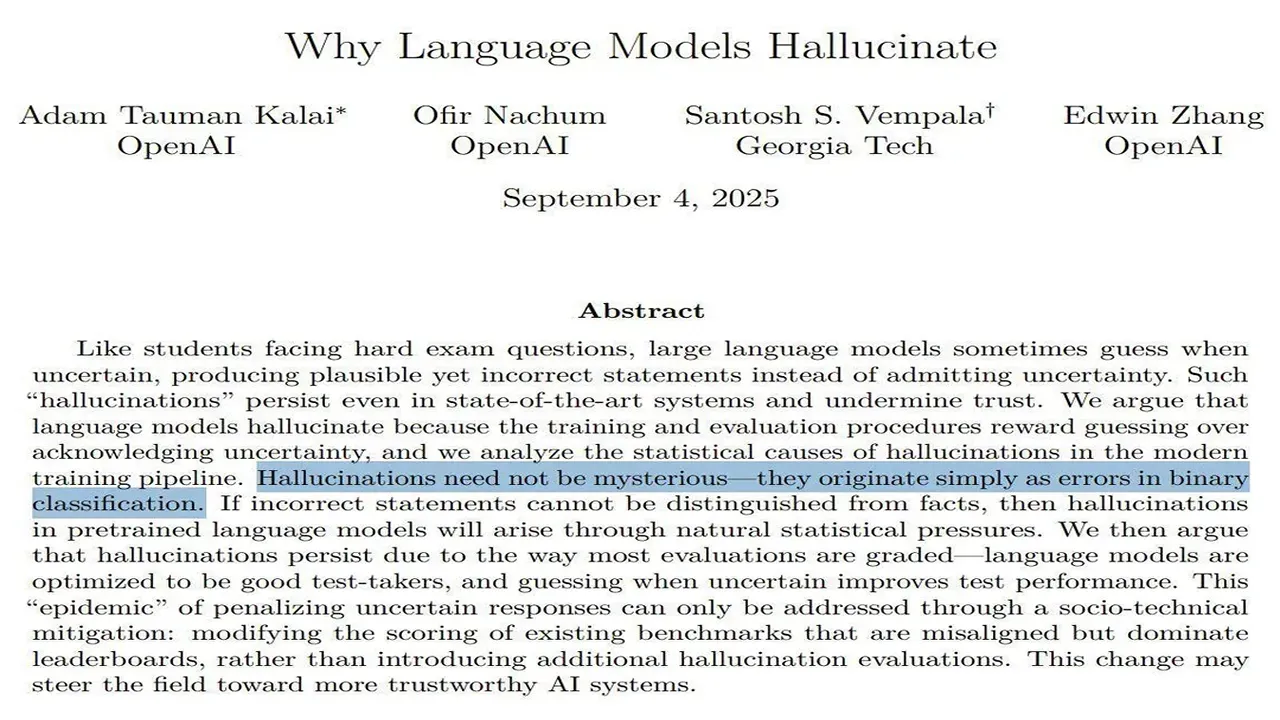

OpenAI ha publicado una investigación que explica la razón fundamental de las alucinaciones en los grandes modelos de lenguaje (LLM). Según el artículo publicado en arXiv, el problema no reside tanto en la arquitectura de los modelos como en los métodos utilizados para entrenarlos y evaluarlos. Los benchmarks y sistemas de evaluación actuales están diseñados de tal manera que animan al modelo a dar cualquier respuesta plausible en lugar de admitir que no lo sabe. Al igual que un estudiante en un examen sin penalización por respuestas incorrectas, para un LLM es estadísticamente más ventajoso "adivinar" y potencialmente obtener un punto que decir "no lo sé" y garantizar un cero. Por lo tanto, el paradigma de entrenamiento y prueba existente penaliza sistemáticamente la expresión de incertidumbre y recompensa las respuestas seguras pero potencialmente falsas. OpenAI hace un llamado a cambios "sociotécnicos": una revisión de los benchmarks populares y la implementación de métricas que valoren no solo la precisión, sino también la "incertidumbre calibrada", la capacidad del modelo para evaluar honestamente su propio conocimiento.

Investigación de OpenAI: los Modelos Alucinan porque son Recompensados por "Adivinar"