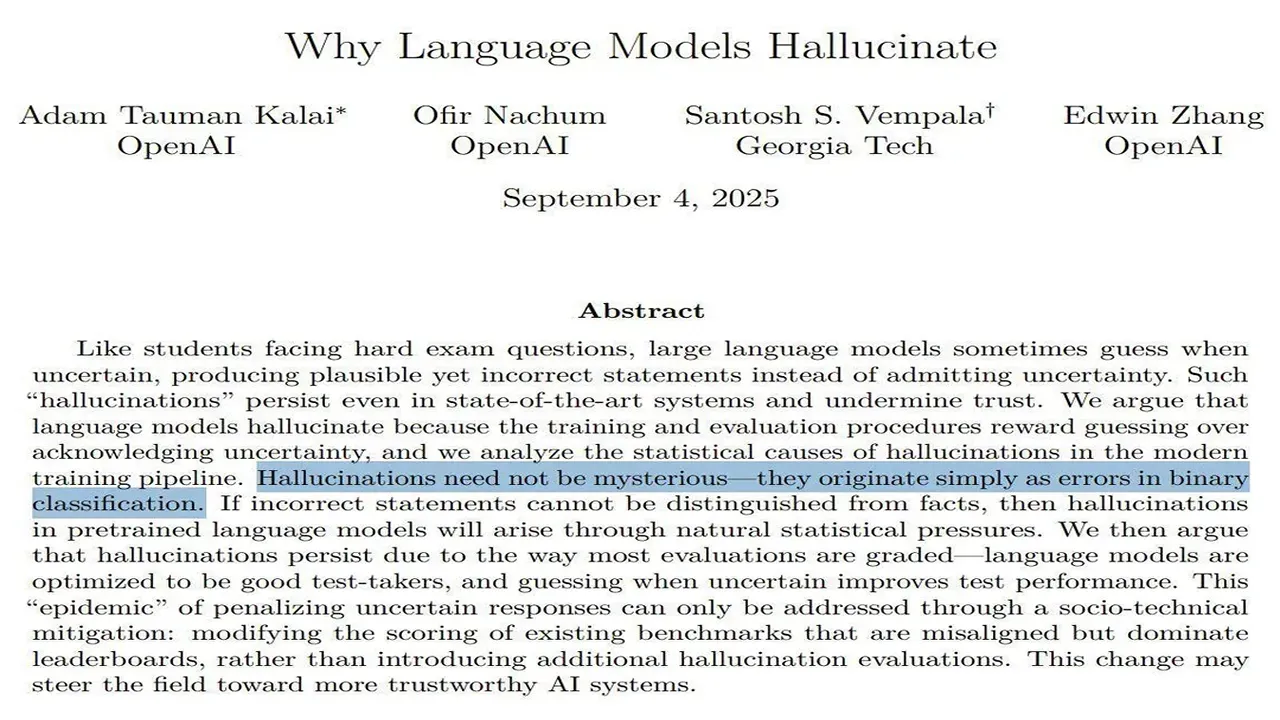

Компания OpenAI опубликовала исследование, в котором объяснила фундаментальную причину галлюцинаций у больших языковых моделей (LLM). Согласно статье, опубликованной на arXiv, проблема кроется не столько в архитектуре моделей, сколько в методах их обучения и оценки. Современные бенчмарки и системы оценки устроены так, что они поощряют модель дать любой правдоподобный ответ, вместо того чтобы признаться в незнании. Подобно студенту на экзамене без штрафа за неверный ответ, LLM статистически выгоднее "угадать" и потенциально получить балл, чем сказать "я не знаю" и гарантированно получить ноль. Таким образом, существующая парадигма обучения и тестирования систематически наказывает за проявление неуверенности и вознаграждает за уверенные, но потенциально ложные ответы. OpenAI призывает к "социо-техническим" изменениям: пересмотру популярных бенчмарков и внедрению метрик, которые будут ценить не только точность, но и "калиброванную неуверенность" — способность модели честно оценивать свою осведомленность.

Исследование OpenAI: модели галлюцинируют, потому что их поощряют "угадывать"